Di chi è la colpa se l’intelligenza artificiale sbaglia

Ci sono ancora vuoti legislativi ed etici da esplorare e a cui dare risposta

3 Maggio 2018

Ci affidiamo sempre di più a sistemi di intelligenza artificiale per migliorare la qualità della nostra vita o dei processi organizzativi, informativi e produttivi. Così, abbiamo sistemi di AI che possono valutare se concedere un mutuo, se evitare un ostacolo nel percorso, se il bersaglio acquisito è quello giusto, oppure se quel post che abbiamo pubblicato trasgredisce una qualche regola del sistema. Decisioni che non sono mai banali, anche se possono sembrarlo data la velocità e la facilità con cui sono prese. Decisioni che, in molti casi, possono avere un impatto notevole sulla vita di una persona o di un gruppo di persone.

Automazione e responsabilità delle decisioni

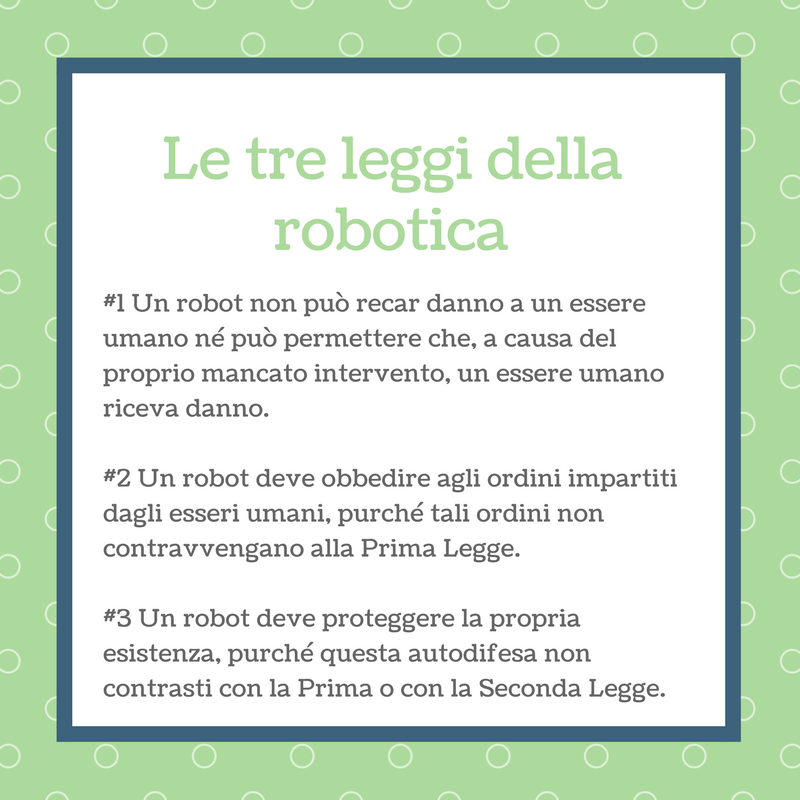

Ci sono molti articoli su questo argomento, che fu già fonte di ispirazione di un grande numero di romanzi e racconti di fantascienza. Non si può certo omettere di citare Isaac Asimov, uno tra i più prolifici scrittori di fantascienza e divulgazione scientifica, ideatore delle altrettanto famose tre leggi della robotica. Ve le ricordate? Secondo un documento pubblicato di recente da una commissione del parlamento della Gran Bretagna, ai sistemi attualmente in uso andrebbero applicati questi nuovi principi:

Secondo un documento pubblicato di recente da una commissione del parlamento della Gran Bretagna, ai sistemi attualmente in uso andrebbero applicati questi nuovi principi:

- l’Intelligenza artificiale dovrebbe essere sviluppata per il bene comune e a beneficio dell’umanità

- l’Intelligenza artificiale dovrebbe operare secondo i principi di accessibilità ed equità

- l’Intelligenza artificiale non dovrebbe essere usata per diminuire i diritti delle persone, famiglie o comunità sui loro dati e sulla loro privacy

- tutti i cittadini dovrebbero avere il diritto di essere educati e crescere emozionalmente ed economicamente insieme con i sistemi di AI

- il potere autonomo di ferire, distruggere o ingannare essere umani non dovrebbe mai essere dato ad un sistema di AI

L’intelligenza artificiale può uccidere, non solo cambiare la tua vita

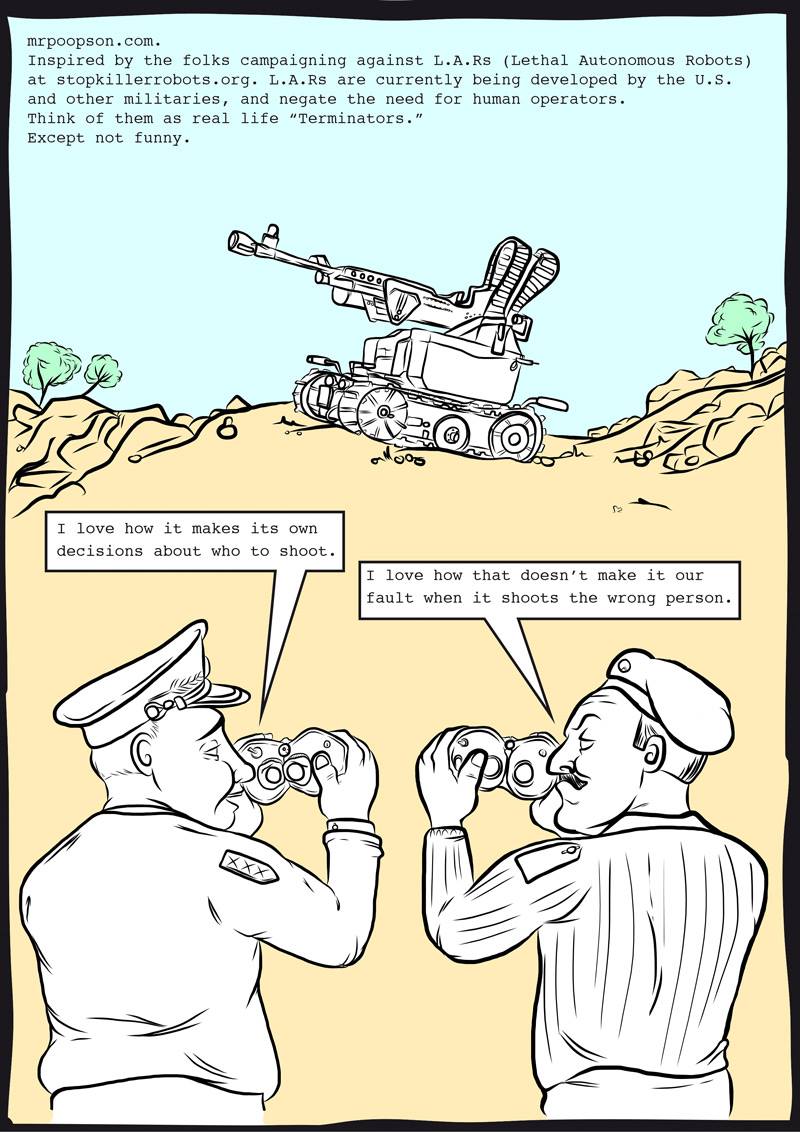

Vi sarà subito venuto in mente l’incidente in cui una automobile a guida autonoma ha investito e ucciso una persona. Ci sono stati altri incidenti, ma questo è il primo in cui una persona è morta, per quanto si sa finora, solo per causa di un sistema AI e non per la concorrenza di altri fattori come in altri casi. Anche i sistemi di intelligenza artificiale utilizzati dai militari hanno sbagliato in passato, abbattendo coi loro missili aerei amici. LEGGI ANCHE: Dobbiamo davvero temere le intelligenze artificiali quanto gli umani? Sono almeno 76 i paesi al mondo che hanno già in uso da alcuni anni quelli che potremmo definire robot killer, nella forma di droni o sistemi semi-automatici Sistemi che possono prendere in base agli input dei loro sensori e gli algoritmi che li controllano decisioni di vita e di morte sugli esseri umani, siano essi il bersaglio primario o, come crudelmente sono definiti a volte, danni collaterali. Delegare simili decisioni ad un sistema automatico, per quanto intelligente, significa scaricare le implicazioni morali e la responsabilità di simili decisioni. Bene lo illustra la vignetta pubblicata su Facebook dal movimento Stop the killer robots. Uno dei militari dice “Adoro come prende decisioni da solo su a chi sparare” e l’altro risponde: “Io adoro che non sia colpa nostra quando spara alla persona sbagliata”.

Secondo Denise Garcia, esperta in leggi internazionali e collaboratrice di Foreign Affairs, sono almeno quattro i rami della legge internazionale che sono stati utilizzati per limitare la violenza della guerra: la legge sulla responsabilità dello stato, la legge sull’uso della forza, la legge umanitaria internazionale e le leggi sui diritti umani.

L’aspetto più preoccupante è che la rimozione della responsabilità delle persone relativamente alle azioni compiute dall’intelligenza artificiale potrebbe portare a future sistematiche violazioni dei diritti umani.

Così, l’ONU sta cercando di negoziare l’uso di questi sistemi, mettendoli al bando definitivamente, e alcuni paesi (USA e UK, per esempio) spingono per lasciare fuori da questa moratoria i sistemi che sono già in via di sviluppo.

Christof Heyns, esperto di leggi sui diritti umani e membro dell’alto commissariato per i diritti umani ha recentemente dichiarato: “se non c’è un bando preventivo delle armi autonome di alto livello, una volta che il genio sarà uscito dalla lampada, sarà molto difficile rimettercelo”.

Solo per ricordare come gli algoritmi possano limitare i nostri diritti, di recente la Cina ha introdotto un sistema di social scoring, in base al quale i cittadini possono (o no) accedere a certi servizi. Sempre in Cina, grazie alla diffusione dei sistemi di videosorveglianza e all’uso di sistemi di riconoscimento facciale, un latitante è stato catturato mentre si godeva una partita allo stadio, pensando di potersi confondere tra la folla.

LEGGI ANCHE: Perché la Cina darà migliori servizi ai cittadini che si faranno spiare

In questi giorni anche Facebook ha chiesto a ciascuno di poter utilizzare il riconoscimento facciale per identificarci nella foto che vengono pubblicate. Cosa vorrà dire davvero?

Uno dei militari dice “Adoro come prende decisioni da solo su a chi sparare” e l’altro risponde: “Io adoro che non sia colpa nostra quando spara alla persona sbagliata”.

Secondo Denise Garcia, esperta in leggi internazionali e collaboratrice di Foreign Affairs, sono almeno quattro i rami della legge internazionale che sono stati utilizzati per limitare la violenza della guerra: la legge sulla responsabilità dello stato, la legge sull’uso della forza, la legge umanitaria internazionale e le leggi sui diritti umani.

L’aspetto più preoccupante è che la rimozione della responsabilità delle persone relativamente alle azioni compiute dall’intelligenza artificiale potrebbe portare a future sistematiche violazioni dei diritti umani.

Così, l’ONU sta cercando di negoziare l’uso di questi sistemi, mettendoli al bando definitivamente, e alcuni paesi (USA e UK, per esempio) spingono per lasciare fuori da questa moratoria i sistemi che sono già in via di sviluppo.

Christof Heyns, esperto di leggi sui diritti umani e membro dell’alto commissariato per i diritti umani ha recentemente dichiarato: “se non c’è un bando preventivo delle armi autonome di alto livello, una volta che il genio sarà uscito dalla lampada, sarà molto difficile rimettercelo”.

Solo per ricordare come gli algoritmi possano limitare i nostri diritti, di recente la Cina ha introdotto un sistema di social scoring, in base al quale i cittadini possono (o no) accedere a certi servizi. Sempre in Cina, grazie alla diffusione dei sistemi di videosorveglianza e all’uso di sistemi di riconoscimento facciale, un latitante è stato catturato mentre si godeva una partita allo stadio, pensando di potersi confondere tra la folla.

LEGGI ANCHE: Perché la Cina darà migliori servizi ai cittadini che si faranno spiare

In questi giorni anche Facebook ha chiesto a ciascuno di poter utilizzare il riconoscimento facciale per identificarci nella foto che vengono pubblicate. Cosa vorrà dire davvero?