Diventa free member

Vuoi leggere questo articolo e le altre notizie e approfondimenti su Ninja? Allora registrati e diventa un membro free. Riceverai Breaking News, Marketing Insight, Podcast, Tips&Tricks e tanto altro. Che aspetti? Tieniti aggiornato con Ninja.

Diventa free member

Vuoi leggere questo articolo, le altre notizie e approfondimenti su Ninja? Allora lascia semplicemente nome e mail e diventa un membro free. Riceverai Breaking News, Marketing Insight, Podcast, Tips&Tricks e tanto altro. Che aspetti? Tieniti aggiornato con Ninja.

Sono moltissimi gli articoli in cui si può leggere quanto i chatbot possano essere una rivoluzione in tutti quei campi in cui, fino a poco tempo fa, una app sembrava la soluzione perfetta.

Sono sicuramente una novità molto interessante, che obbligherà a nuovi approcci e ispirerà nuovi usi (si spera!) del web e dei social media.

In mezzo a tutto questo parlare di chatbot e di quanto siano necessari, ideali e opportuni, c’è qualcuno che si preoccupa di un aspetto forse trascurato: i chatbot possono essere un rischio per la privacy e la sicurezza degli utenti, delle organizzazioni e delle imprese.

Una esagerazione? Forse no, se ricordiamo che il famoso hacker Kevin Mitnick dichiarava che i suoi maggiori successi derivavano più dall’uso di tecniche di social engineering che da quelle puramente informatiche.

Kevin sosteneva infatti che “le persone sono sempre collaborative, specie con chi è carino, informato e insistente” e che “un’azienda può spendere migliaia di dollari in firewall, sistemi antiintrusione e altre tecnologie per la sicurezza, ma se un hacker può chiamare una persona di fiducia dentro l’azienda e la persona acconsente alle sue richieste, allora l’hacker potrà portare a termine il suo attacco e tutti quei soldi sono buttati”.

Un chatbot può essere molto amichevole, sempre disponibile, informato e insistente: lo sanno bene gli studenti del Georgia institute of technology.

Una delle assistenti del professore, Jill Watson, stupì tutti per la sua bravura, cortesia e disponibilità, ricevendo ottimi feedback.

Solo dopo seppero che non interagivano con una persona reale, bensì con un chatbot basato sulla tecnologia IBM Watson.

E se pur c’è chi, sbadato, clicca ancora sul link che trova in uno sgrammaticato messaggio, una buona parte di utenti si è abituata a diffidare e non cade in queste trappole tipiche del phishing.

Ma sarebbero ugualmente portati a diffidare di un amichevole e simpatico chatbot, che durante un piacevole scambio, comincia a strappare informazioni confidenziali?

E che poi, magari, butta lì un link apparentemente innocuo, perché consono al contesto della conversazione, e che invece punta a del malware?

Non dimentichiamo poi che già noi stessi, come semplici e a volte troppo noncuranti utenti di social network, spesso sveliamo molte più informazioni utili ad un malintenzionato di quanto non ci sembri: preferenza musicali, letture, frequentazioni, cibi sono informazioni per noi innocenti, per qualcuno prezioso materiale da utilizzare in un attacco che sfrutti le tecniche del social engineering.

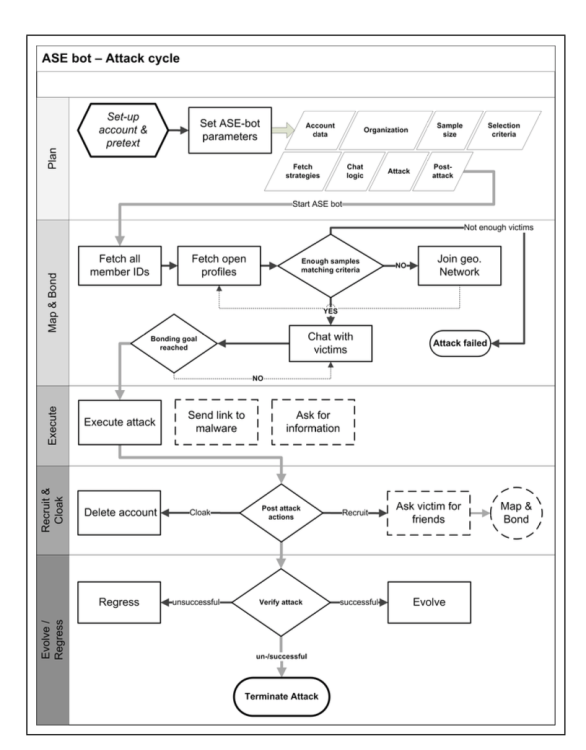

I ricercatori hanno denominato questo tipo di tecnica basata sui chatbot ASE, acronimo di Automated Social Engineering.

Un interessante studio pubblicato da alcuni ricercatori europei (Markus Huber, Stewart Kowalski, Marcus Nohlberg e Simon Tjoa) ha esplorato proprio queste possibilità.

I ricercatori hanno creato un chatbot che, diventato membro di un gruppo di studenti universitari, doveva interagire con loro e poi proporre, come parte del suo attacco, la compilazione di un questionario.

Lo schema di comportamento del BOT usato dai ricercatori europei

La facilità con cui reperire informazioni sull’obbiettivo attraverso il data mining sui social network e il fatto che i meccanismi di sicurezza di Facebook non possano essere troppo restrittivi, hanno fatto concludere al team che sia semplice e fattibile portare a termine attacchi di questo genere.

In fondo, un chatbot non deve superare il famoso test di Turing, in grado di determinare se una macchina o un software siano in grado di pensare: basta che i suoi programmatori riescano a farlo sembrare abbastanza empatico per far percepire alla persona un senso di fiducia ed intimità tale da svelare dati che in un modulo qualsiasi non si sognerebbe di inserire.

Questi dati e informazioni, se memorizzati e registrati, possono essere usati contro l'utente, la sua azienda o la sua organizzazione, da chi ha creato il chatbot, oppure perché no, da chi riesca a impossessarsi di quei dati.

Sembra ancora tutto una esagerazione?

Si pensi al virus che ogni tanto si riaffaccia e colpisce gli utenti di Facebook: Koobface e altri simili. Si propagano proprio sfruttando questo tipo di meccanismo: in diverse fasi dell’attacco e con diverse componenti questi virus leggono la lista degli amici del malcapitato, attiva il sistema di tagging o invia loro un messaggio con un link ad un presunto video in cui compaiono loro stessi.

Un link che invece provoca l’infezione e l’ulteriore propagazione.

Un’altra forma di attacco possibile è quella in cui un chatbot creato da malintenzionati si propone come un legittimato assistente presso la banca cui l'utente si serve, ad esempio.

Una variante dei classici attacchi in cui gli hacker cercano di carpire le credenziali personali, dirottando l'utente verso un sito del tutto simile a quello originale, ma che è invece sotto il loro controllo. Anche in queso caso, spesso è facile riconoscere questi tentativi, perché inseriti in una mail sgrammaticata o dall'aspetto grafico sospetto.

Saremmo in grado di distinguere il solito e compìto assistente digitale, quando dialoghiamo in chat, da uno fasullo?

Facebook e altri social network hanno creato buoni meccanismi di difesa contro lo spam, ma non ancora (o non allo stesso livello) quelli per difendere gli utenti dallo spoofing, l’impersonamento di qualcun altro: un assistente virtuale legittimo o, perché no, un amico.

Insomma, ben venga questa annunciata rivoluzione, a patto di rimanere consapevoli che ci sono dei rischi da prevenire.