Pregiudizi e bias: qual è il rischio delle AI che imparano dagli esseri umani

In un mondo in cui pregiudizi e stereotipi imperversano, come possono le intelligenze artificiali non soccombere ai nostri bias?

3 Marzo 2023

Dieci anni fa, nel 2013, uscì nelle sale “HER”, film diretto da Spike Jonze interpretato magistralmente da Joaquin Phoenix. Il film, che si aggiudicò il premio Oscar per la miglior sceneggiatura originale, parlava dell’amore tra Theodore, un uomo solitario, e Samantha, un sistema operativo, “OS 1”, basato su un’intelligenza artificiale in grado di evolvere, adattandosi alle esigenze dell’utente. Quella nel film è un’intelligenza artificiale che impara ad amare e a provare sentimenti come farebbe una persona. Ma se le IA imparano dagli esseri umani, cosa stiamo insegnando loro?

Intelligenza artificiale o pregiudizi umani?

L’intelligenza artificiale (IA) è l’abilità di una macchina di mostrare capacità umane quali il ragionamento, l’apprendimento, la pianificazione e la creatività, mettendosi in relazione con l’ambiente e cercando di risolvere problemi. Spesso siamo abituati a pensare che l’intelligenza artificiale sia perfetta e infallibile senza ricordarci però che non sono libere da bias che sono contenuti nei dati con cui i modelli vengono addestrati. Un bias è una forma di distorsione cognitiva causata dal pregiudizio e può influenzare ideologie, opinioni e comportamenti. Ecco perché i modelli delle intelligenze artificiali possono ereditare bias basati su razza, genere, religione o altre caratteristiche dai dati che vengono forniti loro.

Un bias è una forma di distorsione cognitiva causata dal pregiudizio e può influenzare ideologie, opinioni e comportamenti. Ecco perché i modelli delle intelligenze artificiali possono ereditare bias basati su razza, genere, religione o altre caratteristiche dai dati che vengono forniti loro.

Amazon, quando l’algoritmo premia i candidati di genere maschile

Nel 2014 Amazon decise di utilizzare un software di recruitment per analizzare i curriculum dei candidati e automatizzare la procedura di selezione. La cosa incredibile fu che l’algoritmo penalizzò le donne, soprattutto per le posizioni inerenti a ruoli più tecnologici. Colpa dell’intelligenza artificiale? Certamente no. Infatti, l’errore era dovuto ai dati reali con cui il modello era stato addestrato che riportava tra i CV dei dieci anni precedenti una prevalenza maschile, soprattutto nel settore tecnologico. In quel caso il modello ha acquisito un pattern che riconosceva, tra le caratteristiche ideali per i migliori candidati, il genere maschile.MidJourney, anche le immagini mostrano i pregiudizi

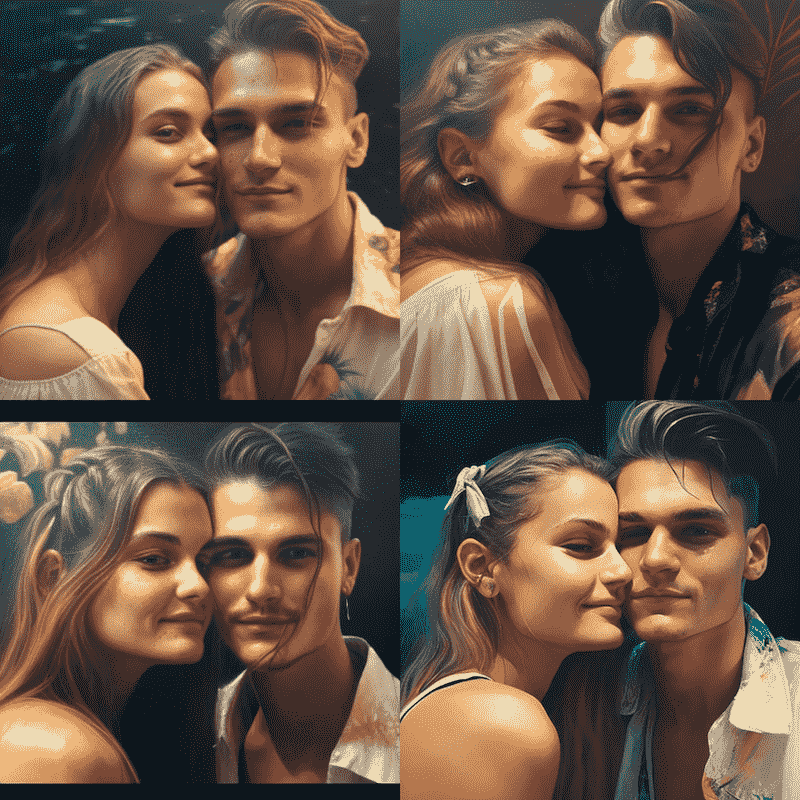

A proposito di pregiudizi legati al genere, recentemente Wired e TBWAItalia, hanno creato una campagna di denuncia proprio rispetto agli stereotipi che contaminano le intelligenze artificiali. L’indagine ha mostrato come, inserendo determinate parole su MidJourney, il sistema di AI capace di realizzare immagini grazie alle istruzioni fornite dagli utenti, il risultato fosse condizionato dai bias “umani”. Ad esempio, inserendo la parola inglese “manager”, le immagini rilasciate da MidJourney erano tutte di uomini cis gender bianchi, in giacca e cravatta. Con la ricerca “emotive”, invece, l’algoritmo mostrava donne bianche, giovani, in lacrime. Non solo di genere sono le discriminazioni mostrate da MidJourney. Infatti, i risultati per la parola “Lovers” hanno mostrato solo ritratti di uomini e donne dai tratti caucasici. Non c’era traccia di coppie omosessuali o di altre etnie. Stessa sorte per il prompt “Parents”: le coppie sono bianche ed eterosessuali.

LEGGI ANCHE: Come creare prompt per immagini AI efficaci: la guida

Non solo di genere sono le discriminazioni mostrate da MidJourney. Infatti, i risultati per la parola “Lovers” hanno mostrato solo ritratti di uomini e donne dai tratti caucasici. Non c’era traccia di coppie omosessuali o di altre etnie. Stessa sorte per il prompt “Parents”: le coppie sono bianche ed eterosessuali.

LEGGI ANCHE: Come creare prompt per immagini AI efficaci: la guida

Coded Bias, cosa succede se sei una donna di colore?

Joy Boulamwini è un’informatica del MIT Media Lab, è una donna di origini ghanesi. Ha fondato l’Algorithmic Justice League, un’associazione che si occupa di controllare le ingiustizie dell’intelligenza artificiale. A lei si deve lo studio dei pregiudizi del facial recognition del 2018, secondo cui gli algoritmi hanno imparato dalla nostra società patriarcale e razzista. La ricercatrice ghanese è la protagonista del documentario “Coded Bias”, diretto da Shalini Kantayya e disponibile su Netflix. Il docufilm ha inizio dal racconto dell’episodio che ha coinvolto e spinto Joy Boulamwini a studiare gli errori dell’IA. L’algoritmo non la riconosceva, come se il suo viso di donna di colore fosse invisibile per lo strumento. Indossando una maschera bianca, nonostante fosse del tutto anonima per via dell’assenza della sua fisionomia, veniva isolata dal sistema di riconoscimento. Ancora una volta l’intelligenza artificiale ha appreso una storia di razzismo e sessismo che fanno parte dei bias della nostra società. LEGGI ANCHE: 7 cose da sapere su ChatGPT prima di utilizzarlo per i contenuti e per la SEOCosa possiamo fare per combattere i pregiudizi dell’intelligenza artificiale?

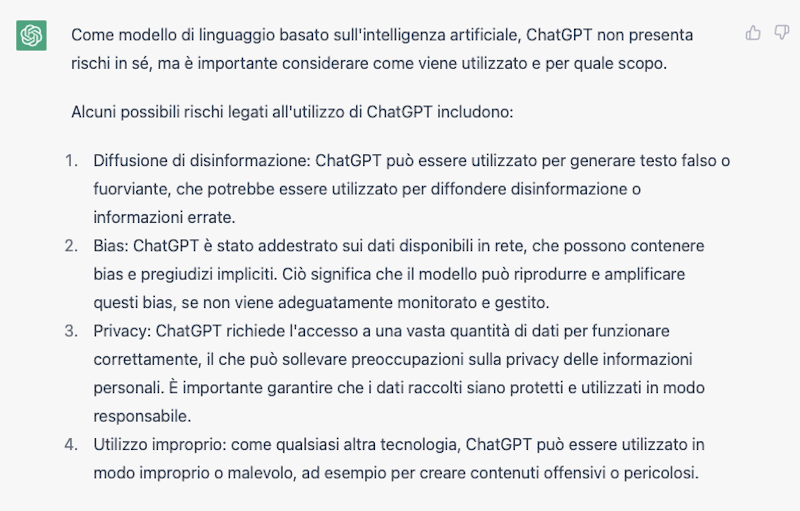

Ninareh Mehrabi, nel suo paper “A Survey on Bias and Fairness in Machine Learning”, ha esposto come una prima difficoltà sia la mancanza di una definizione esaustiva e universale di correttezza, poiché le definizioni possono variare a seconda dei diversi contesti politici e sociali. Non è un caso che la stessa ChatGPT, interrogata su eventuali pericoli sul suo uso, dichiari come secondo punto i bias e i pregiudizi impliciti.

Da tempo il tema dell’etica dell’intelligenza artificiale è al centro di un dibattito sociale che riguarda non soltanto i grandi player del mercato ma soprattutto i legislatori che devono garantire tutele in materia.

Una cosa è certa, le intelligenze artificiali imparano da noi, ma noi ancora non abbiamo imparato a vivere in un mondo privo di pregiudizi, di stereotipi e di disuguaglianze. Risolvere i bias dell’algoritmo è facile, molto più difficile risolvere quelli delle persone.

Non è un caso che la stessa ChatGPT, interrogata su eventuali pericoli sul suo uso, dichiari come secondo punto i bias e i pregiudizi impliciti.

Da tempo il tema dell’etica dell’intelligenza artificiale è al centro di un dibattito sociale che riguarda non soltanto i grandi player del mercato ma soprattutto i legislatori che devono garantire tutele in materia.

Una cosa è certa, le intelligenze artificiali imparano da noi, ma noi ancora non abbiamo imparato a vivere in un mondo privo di pregiudizi, di stereotipi e di disuguaglianze. Risolvere i bias dell’algoritmo è facile, molto più difficile risolvere quelli delle persone.

Come migliorare il Marketing con l’Intelligenza Artificiale

Spingiti oltre i tuoi limiti con il Corso AI Marketing di Ninja Academy: porta nella tua professione digitale le potenzialità di ChatGPT e delle Intelligenze Artificiali e dai un boost alle tue strategie. Ancora per pochi giorni, puoi iscriverti al corso qui.

Spingiti oltre i tuoi limiti con il Corso AI Marketing di Ninja Academy: porta nella tua professione digitale le potenzialità di ChatGPT e delle Intelligenze Artificiali e dai un boost alle tue strategie. Ancora per pochi giorni, puoi iscriverti al corso qui.