Come spiegare l’intelligenza artificiale ai propri nonni

La sfida è quella di capire le nuove tecnologie partendo dalle loro applicazioni pratiche

- Anche i nonni iniziano a fare i conti con la tecnologia, con molte difficoltà

- L’AI fa parte delle nostre vite, ma siamo lontani dalla creazione di un sistema intelligente

- L’intelligenza artificiale porterà ulteriori e notevoli vantaggi alla società attuale

Molti dei nostri nonni stanno iniziando a fare i conti con la comprensione della tecnologia e non solo con un uso passivo: guardandosi attorno è possibile notare che sono sempre di più gli over 65 che si iscrivono ai social network, navigano abitualmente sul web, fanno videochiamate e comprano smartphone all’ultimo grido. Anche le statistiche ISTAT lo confermano, almeno l’80% della popolazione over 60 ha usato internet una volta nella vita e circa un anziano su tre, tra i 65 e i 75 anni, ha navigato nel web nell’ultimo anno. Il 13% dichiara di usarlo addirittura tutti i giorni.

Tuttavia, è noto che il grey digital divide, ovvero il divario tra l’utilizzo delle nuove tecnologie da parte della popolazione anziana, rispetto al resto della popolazione, è ancora parecchio marcato. Ci sono barriere difficili da superare, legate sia a problemi attitudinali che alla difficoltà nell’apprendimento dell’uso dei nuovi strumenti di comunicazione. E spiegare determinati concetti per noi nativi digitali, non è per niente semplice.

Ci capita spesso di avere difficoltà a spiegare le nostre professioni a una persona che ha poca confidenza con il web, figuriamoci spiegare un concetto complesso come quello dell’intelligenza artificiale. Ma facciamo comunque un tentativo.

LEGGI ANCHE: L’Intelligenza Artificiale potrebbe completare la Decima di Beethoven

Cos’è e come funziona l’intelligenza artificiale?

Il termine Artificial Intelligence (AI), coniato nel 1956 dall’informatico statunitense John McCarthy, sottintende un campo di studi che consente alle macchine di “pensare” e mettere in atto comportamenti tipici dell’uomo, ad esempio comprendere il linguaggio naturale, ragionare, interagire con le persone, le macchine e l’ambiente. Come? Tramite tecniche di apprendimento automatico.

La nonna avrà capito? Mi sa di no. Proviamo con un esempio.

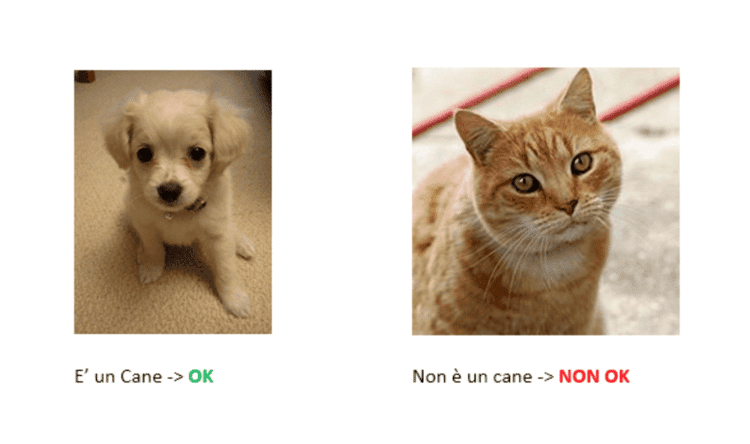

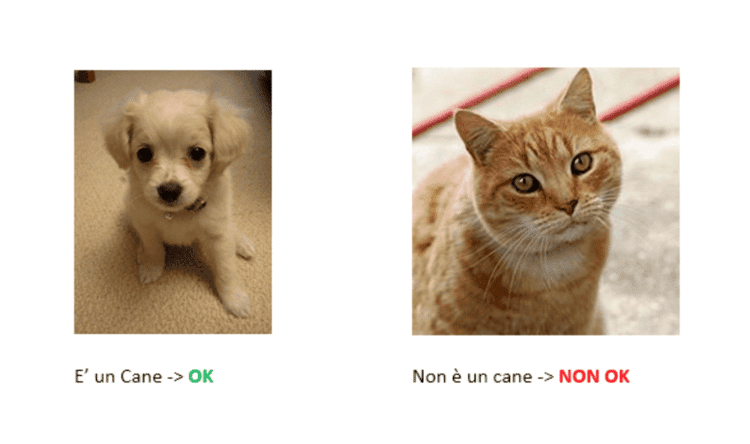

Immaginiamo di dover sistemare una serie di fotografie all’interno di diversi album e di doverle dividere in base al soggetto. A noi uomini basterebbe una semplice occhiata per poterle classificare ed inserire nel raccoglitore corrette. Ma se questo compito lo dovesse svolgere un computer, anziché una persona? Per poterlo fare, bisognerebbe rendere il computer capace di riconoscere e categorizzare le immagini. A questo scopo gli studiosi hanno inventato le reti neurali, soluzioni matematiche che, ispirandosi al funzionamento del cervello, agiscono imparando a selezionare l’immagine corretta, mediante le informazioni che sono in grado di raccogliere. Più informazioni riesce a memorizzare un computer, meno sarà difficile sbagliare le operazioni successive.

Molto spesso, quando si sente parlare di intelligenza artificiale, siamo abituati a pensare ai robot che ci raccontano i film, come Terminator e Blade Runner, ma non ci accorgiamo che in realtà essa è già presente nelle nostre giornate quotidiane e vi interagiamo continuamente.

LEGGI ANCHE: Sì, l’Intelligenza Artificiale può aiutare a salvare le specie in estinzione

Molto spesso, quando si sente parlare di intelligenza artificiale, siamo abituati a pensare ai robot che ci raccontano i film, come Terminator e Blade Runner, ma non ci accorgiamo che in realtà essa è già presente nelle nostre giornate quotidiane e vi interagiamo continuamente.

LEGGI ANCHE: Sì, l’Intelligenza Artificiale può aiutare a salvare le specie in estinzione

Com’è nata l’intelligenza artificiale?

Le prime tracce della cosiddetta “AI – Intelligenza Artificiale” come disciplina scientifica risalgono agli anni Cinquanta: in questo ambito ebbe un ruolo fondamentale Alan Turing. Nel suo articolo “Macchine e intelligenza informatica” spiegò un esperimento noto come “test di Turing”, secondo cui una macchina poteva essere definita intelligente dal momento in cui il suo comportamento sarebbe stato considerato indistinguibile da quello di una persona.

Come nacque l’interesse per questo tema? Negli anni ‘40 si scoprì che la struttura interna del cervello è composta da una rete di neuroni che trasmettono impulsi elettrochimici ed iniziarono a chiedersi: sarebbe possibile replicarne il funzionamento? Da questa idea ebbe origine il progetto di una macchina pensante, capace di parlare, ragionare, imparare, esattamente come una persona. A partire da quegli anni ci fu un periodo di incessante ricerca, che portò ad enormi successi: McCulloch e Walter Pitts crearono il primo modello di rete neurale ispirato al cervello (1943), Marvin Minsky e Dean Edmonds svilupparono il primo “neuro computer” (1951), mentre Allen Newell e Herbert A. Simpson svilupparono il primo vero sistema AI (1955).

Se inizialmente questa disciplina aveva nomi diversi (ad esempio “programmazione euristica” o “sistema intelligente”), nel 1956 prevale il termine “intelligenza artificiale“. Questa definizione venne usata per la prima volta da John McCarthy, durante uno storico convegno dedicato, tenutosi a Dartmouth. Durante gli anni successivi alla nascita dell’Intelligenza Artificiale ci furono molte sperimentazioni e anche le aspettative iniziarono a crescere, ma i macchinari dell’epoca non disponevano di una capacità adeguata. Di conseguenza, a partire dagli anni ‘70 si passò ad un approccio più pragmatico. Oggi l’intelligenza artificiale non è più un’ipotesi, ma trova applicazione in diversi ambiti.

La strada da percorrere per creare un vero “sistema intelligente”, però, è ancora lunga.

LEGGI ANCHE: I ricercatori di IBM vogliono usare l’Intelligenza Artificiale contro l’Alzheimer

LEGGI ANCHE: L’etica dell’intelligenza artificiale

LEGGI ANCHE: L’etica dell’intelligenza artificiale

Come si può classificare l’intelligenza artificiale?

Anche se siamo ancora molto distanti dalla creazione di una vera e propria “intelligenza artificiale”, i progressi ottenuti in questi anni non hanno precedenti: automobili che si guidano da sole, assistenti vocali, sistemi di riconoscimento delle immagini, orologi che monitorano i nostri parametri vitali, ma anche macchine in grado di sostituire i lavoratori per specifiche mansioni.

Due sono stati gli approcci perseguiti per raggiungere questo risultato: il primo consisteva nel costruire dei software capaci di replicare l’uomo nel modo di ragionare e nel comportamento; il secondo, invece, prevedeva di far assumere un determinato atteggiamento alla macchina basato su un problema posto dalla realtà.

Di conseguenza sono state definite due tipologie di AI:

- intelligenza artificiale debole, quando un software è in in grado di simulare alcune funzionalità cognitive dell’uomo, senza raggiungere le piene capacità intellettuali. I sistemi attualmente in uso possono essere classificati all’interno di questa categoria;

- intelligenza artificiale forte, quando un software è in grado di sviluppare una propria capacità intellettuale, senza dover emulare l’uomo. I più ottimisti pensano che un giorno sarà possibile ottenere una macchina con queste capacità.

Artificial intelligence debole e forte stanno alla base della distinzione tra:

- machine learning, o apprendimento automatico, consiste in un insieme di tecniche che permettono alle macchine di “imparare” dai dati e prendere decisioni. Alcuni esempi per questo tipo di sistema di intelligenza artificiale sono il riconoscimento facciale (Facebook), la classificazione degli oggetti, etc. L’apprendimento può essere svolto con tre modalità: mediante esempi (con supervisione didattica), mediante l’analisi dei risultati (senza supervisione didattica) e mediante un premio al raggiungimento di un risultato (reinforcement learning);

- deep learning, o apprendimento approfondito, consiste in un insieme di tecniche che cercano di emulare la struttura e la funzione della mente umana (reti neurali artificiali). Se il nostro cervello, per formulare una risposta ad un quesito o arrivare alla risoluzione di un problema, mette in moto i propri neuroni biologici, il deep learning sfrutta le connessioni neurali. Alcuni esempi per questo tipo di sistema di intelligenza artificiale sono il riconoscimento automatico della lingua parlata, l’elaborazione del linguaggio naturale (NLP), etc.

LEGGI ANCHE: Meena, il più avanzato sistema di Chatbot di Google

LEGGI ANCHE: Meena, il più avanzato sistema di Chatbot di Google

Opportunità e rischi dell’AI nel 2020

L’intelligenza artificiale è uno strumento che potrebbe portare notevoli vantaggi alla società attuale. In primis perché è in grado di fornire soluzioni semplici per la vita di tutti i giorni. Basti pensare agli assistenti vocali e ai sistemi di smart home, come Siri, Google Home, Alexa, Cortana, che sfruttano l’intelligenza artificiale, sia per il riconoscimento del linguaggio naturale, che per l’analisi delle abitudini e dei comportamenti degli utenti, ma anche ai frigoriferi intelligenti che segnalano gli ingredienti che mancano, alle automobili a guida autonoma e ai sensori intelligenti, capaci di elaborare in tempo reale i percorsi più convenienti e veloci. Per non parlare degli assistenti virtuali, che potrebbero essere un valido sostegno per gli anziani, facendo compagnia, ricordando di mangiare e assumere farmaci, inviando richieste di soccorso in caso di necessità, etc.

Inoltre, l’AI troverebbe applicazione anche nell’ambito del lavoro. Molte attività, grazie all’intelligenza artificiale, potrebbero essere svolte con un grado di accuratezza molto più elevato, con un margine di errore inferiore e molto più rapidamente. Se, da un lato, l’automazione potrebbe lasciare alcuni impiegati senza lavoro (timore giustificato dal fatto che la metà delle attività lavorative potrebbe essere automatizzata entro il 2055, secondo il report “A Future That Works: Automation, Employment and Productivity”, realizzato dal McKinsey Global Institute), è altrettanto vero che potrebbero delinearsi nuove figure professionali, capaci di costruire, mantenere, operare e regolare queste tecnologie emergenti. Questo vantaggio è confermato da uno studio: un report di Capgemini intitolato “Turning AI into concrete value”.

L’intelligenza artificiale applicata alle vendite, ad esempio mostra risultati davvero significativi: grazie all’utilizzo di sistemi esperti, le persone sono in grado di trovare risposte ai loro problemi, scegliere il prodotto più appropriato, senza richiedere l’intervento di un professionista. Il funzionamento è molto semplice: se si ha un problema, basta collegarsi al sito web o alla app per fare una domanda alla macchina ed ottenere una risposta immediata.

Ma non solo, in caso di difficoltà di scelta, il sistema è in grado di elaborare le risposte dell’utente per fare domande sempre più accurate e arrivare a definire una proposta commerciale valida. Quello che l’AI sta cercando di fare è rendere questi sistemi sempre più “umani”, lavorando sul tone of voice e sullo stile espressivo: in questo modo sarà possibile instaurare una connessione emozionale con gli utenti e aumentarne il coinvolgimento.

In terzo luogo, l’intelligenza artificiale potrebbe portare enormi vantaggi al sistema sanitario: può essere utilizzata per individuare precocemente un problema, per fare una diagnosi rapida di malattie rare, individuando dettagli che spesso sfuggono all’occhio umano, ma anche per trovare nuove cure e trattamenti sperimentali e per monitorare i parametri vitali. Già oggi sono disponibili sul mercato sistemi cognitivi in grado di attingere e analizzare una grande quantità di dati, e di dedurre soluzioni. Ma non solo, gli assistenti virtuali basati su AI stanno iniziando a supportare i servizi di primo soccorso, le sale operatorie, i disabili (in particolare quelli che non sono in grado di parlare, o di camminare).

Un esempio recente di applicazione dell’intelligenza artificiale nell’ambito medico si è visto a Wuhan, nel corso dell’emergenza Coronavirus, dove sono stati usati sistemi per le diagnosi precoci delle polmoniti e il monitoraggio della malattia, in grado di fornire una risposta attendibile al 98,5%, in soli 20 secondi. La capacità di analizzare grandissime quantità di dati in tempo reale e di “dedurre” attraverso correlazioni di eventi, abitudini, comportamenti, offre un potenziale enorme non solo per la medicina, ma anche per il miglioramento dell’efficienza della sicurezza pubblica, la prevenzione e la gestione della crisi in casi di calamità naturali.

LEGGI ANCHE: Applicazioni e opportunità dell’intelligenza artificiale nell’healthcare

D’altra parte, però, esistono anche dei rischi da tenere in considerazione, oltre alla potenziale perdita di lavoro. Un ipotetico pericolo che molti temono è che l’essere umano possa essere sottomesso da una tecnologia dotata di un’intelligenza superiore, la cosiddetta “super intelligenza”. Altri, invece, non trovano rischi nell’inferiorità, ma nella dipendenza dalla tecnologia e nella salvaguardia della privacy. Questi timori, alimentati da personaggi di spicco come Stephen Hawking ed Elon Musk, potrebbero apparire eccessivi, ma sottovalutare gli impatti dell’Intelligenza Artificiale potrebbe rappresentare il primo fattore di rischio. Un ulteriore problema è rappresentato dalle cosiddette “bolle di filtraggio”. Se i contenuti suggeriti dagli algoritmi delle macchine influenzano l’utente

D’altra parte, però, esistono anche dei rischi da tenere in considerazione, oltre alla potenziale perdita di lavoro. Un ipotetico pericolo che molti temono è che l’essere umano possa essere sottomesso da una tecnologia dotata di un’intelligenza superiore, la cosiddetta “super intelligenza”. Altri, invece, non trovano rischi nell’inferiorità, ma nella dipendenza dalla tecnologia e nella salvaguardia della privacy. Questi timori, alimentati da personaggi di spicco come Stephen Hawking ed Elon Musk, potrebbero apparire eccessivi, ma sottovalutare gli impatti dell’Intelligenza Artificiale potrebbe rappresentare il primo fattore di rischio. Un ulteriore problema è rappresentato dalle cosiddette “bolle di filtraggio”. Se i contenuti suggeriti dagli algoritmi delle macchine influenzano l’utente (

portandolo a cambiare atteggiamento), la sua visione delle cose che succedono nel mondo potrebbe essere destinata a restringersi e rischierebbe di rimanere intrappolato in una vera e propria “bolla ideologica”.

Capito nonna? L’intelligenza artificiale fa parte delle nostra quotidianità. È importante che si capisca come sfruttarla a nostro favore e non lasciarci sopraffare.

Molto spesso, quando si sente parlare di intelligenza artificiale, siamo abituati a pensare ai robot che ci raccontano i film, come Terminator e Blade Runner, ma non ci accorgiamo che in realtà essa è già presente nelle nostre giornate quotidiane e vi interagiamo continuamente.

LEGGI ANCHE: Sì, l’Intelligenza Artificiale può aiutare a salvare le specie in estinzione

Molto spesso, quando si sente parlare di intelligenza artificiale, siamo abituati a pensare ai robot che ci raccontano i film, come Terminator e Blade Runner, ma non ci accorgiamo che in realtà essa è già presente nelle nostre giornate quotidiane e vi interagiamo continuamente.

LEGGI ANCHE: Sì, l’Intelligenza Artificiale può aiutare a salvare le specie in estinzione

LEGGI ANCHE: L’etica dell’intelligenza artificiale

LEGGI ANCHE: L’etica dell’intelligenza artificiale

LEGGI ANCHE: Meena, il più avanzato sistema di Chatbot di Google

LEGGI ANCHE: Meena, il più avanzato sistema di Chatbot di Google

D’altra parte, però, esistono anche dei rischi da tenere in considerazione, oltre alla potenziale perdita di lavoro. Un ipotetico pericolo che molti temono è che l’essere umano possa essere sottomesso da una tecnologia dotata di un’intelligenza superiore, la cosiddetta “super intelligenza”. Altri, invece, non trovano rischi nell’inferiorità, ma nella dipendenza dalla tecnologia e nella salvaguardia della privacy. Questi timori, alimentati da personaggi di spicco come Stephen Hawking ed Elon Musk, potrebbero apparire eccessivi, ma sottovalutare gli impatti dell’Intelligenza Artificiale potrebbe rappresentare il primo fattore di rischio. Un ulteriore problema è rappresentato dalle cosiddette “bolle di filtraggio”. Se i contenuti suggeriti dagli algoritmi delle macchine influenzano l’utente (portandolo a cambiare atteggiamento), la sua visione delle cose che succedono nel mondo potrebbe essere destinata a restringersi e rischierebbe di rimanere intrappolato in una vera e propria “bolla ideologica”.

Capito nonna? L’intelligenza artificiale fa parte delle nostra quotidianità. È importante che si capisca come sfruttarla a nostro favore e non lasciarci sopraffare.

D’altra parte, però, esistono anche dei rischi da tenere in considerazione, oltre alla potenziale perdita di lavoro. Un ipotetico pericolo che molti temono è che l’essere umano possa essere sottomesso da una tecnologia dotata di un’intelligenza superiore, la cosiddetta “super intelligenza”. Altri, invece, non trovano rischi nell’inferiorità, ma nella dipendenza dalla tecnologia e nella salvaguardia della privacy. Questi timori, alimentati da personaggi di spicco come Stephen Hawking ed Elon Musk, potrebbero apparire eccessivi, ma sottovalutare gli impatti dell’Intelligenza Artificiale potrebbe rappresentare il primo fattore di rischio. Un ulteriore problema è rappresentato dalle cosiddette “bolle di filtraggio”. Se i contenuti suggeriti dagli algoritmi delle macchine influenzano l’utente (portandolo a cambiare atteggiamento), la sua visione delle cose che succedono nel mondo potrebbe essere destinata a restringersi e rischierebbe di rimanere intrappolato in una vera e propria “bolla ideologica”.

Capito nonna? L’intelligenza artificiale fa parte delle nostra quotidianità. È importante che si capisca come sfruttarla a nostro favore e non lasciarci sopraffare.