Le auto a guida autonoma potrebbero essere più lontane di quanto immaginiamo

Ma i problemi che ostacolano il loro avvento non sono tecnologici come potresti pensare

3 Novembre 2019

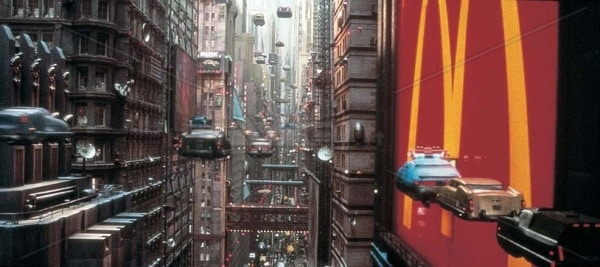

Quante delle storie di fantascienza con cui siamo cresciuti si sono almeno parzialmente realizzate nella realtà? Se ci pensiamo, non sono poche, come ci ricorda la molto attuale Black Mirror. Dai social network alla presenza dei robot e delle AI in molti ambiti delle nostre vite, il presente è sicuramente meno distopico di quanto ce lo avesse raccontato la science-fiction, in modo comunque abbastanza accurato.

Tra i grandi assenti dal panorama delle innovazioni futuristiche che popolano la nostra immaginazione, però, figura lei: l’automobile.

Ci sono state tante innovazioni nel campo dell’automotive, certo, ma il funzionamento della mobilità è ancora molto simile a quello che è si è affermato quando abbiamo lasciato a casa i cavalli. Per restare in tema con l’anniversario dell’allunaggio, non è un campo in cui ci siano stati molti “moonshot thinking” di successo.

E così siamo ancora qui a sperare di vedere le macchine che volano guidandosi da sole che popolavano i cartoni della nostra infanzia.

LEGGI ANCHE: Il futuro delle automobili in 5 trend inarrestabili

Il futuro (non troppo prossimo) dell’automotive

La parte del volo lasciamola perdere, per ora dovremo accontentarci degli aerei dato che, oltre i droni per il trasporto merci, non sembra si stiano orientando grandi investimenti verso questa applicazione. Ma nemmeno la grande innovazione di cui tutti parlano da anni, la guida autonoma, forse è così vicina come ci fanno credere. Siamo già in ritardo di due anni sulle previsioni di Elon Musk, che aveva promesso il 2017 come l’anno dei veicoli autonomi. E probabilmente l’ultimo incidente che ad aprile ha coinvolto una Tesla Model S mentre la modalità di guida semi-automatica era inserita non gioca a favore della sua realizzazione prossima. Il veicolo infatti è dotato di un sistema di guida assistita (nella scala da 1 a 5 dei sistemi di guida autonoma si posiziona al 2) che non prevede che il guidatore stacchi mai le mani dal volante. Nel caso dell’incidente che abbiamo citato, sono in corso verifiche per provare che il sistema fosse o non fosse inserito, ma una cosa è chiara: che le mani siano sul volante o meno, se lo sguardo non lo è, la presenza umana conta poco. Ecco il paradosso. La maggior parte dei sistemi di guida autonoma oggi in commercio che si trovano sulle strade, come la Tesla Model S, non superano il livello 2. Eppure a livello tecnologico, come sostiene Bryan Salesky, CEO di Argo, una delle startup maggiormente all’avanguardia nello sviluppo di programmi di guida autonoma, “l’80% del lavoro di programmazione necessario per mettere i veicoli autonomi su strada è già stato fatto; ci sono i radar, le videocamere, i sensori per identificare oggetti e movimenti, tutto funziona perfettamente. È il 20% restante il difficile“. Perché? Semplicemente per il motivo meno tecnologico di tutti: l’imprevedibilità del comportamento umano.Il problema nelle auto a guida autonoma non è (solo) etico

Hai probabilmente già sentito parlare di Moral Machine, il progetto di ricerca del MIT basato su un sondaggio mondiale legato all’etica nei diversi Paesi. Le auto a guida autonoma erano la perfetta cavia per questo test: cosa avrebbero selezionato le persone, messe davanti a scelte moralmente difficili? Il classico “cosa scegli tra uccidere una persona per salvarne cinque, o cinque persone per salvare un bambino?”. Diciamo che, dal punto di vista scientifico, il risultato ha validità zero e non indica una via percorribile agli ingegneri che si stanno realmente occupando del problema. Anzi. Dopo 18 mesi, 40 milioni di decisioni simulate erano state prese da persone in 233 Paesi, e il dato più interessante che ne è uscito è che la morale non è universale. Risulta infatti, tra le tante cose, che i Paesi orientali considerano meno accettabile di noi “sacrificare” un anziano per salvare un bambino (i pensionati di tutti i Paesi sanno dove trasferirsi, ora), e che quelli di cultura ispanica e francese sono più orientati a salvare le donne. Ma a parte queste colorite differenze geografiche, veniva fuori chiaramente un paradosso: nella maggior parte dei casi, dai sondaggi risultava che gli utenti preferirebbero che un’auto a guida autonoma salvasse i pedoni a scapito del suo equipaggio…ma anche che non comprerebbero un’auto a guida autonoma programmata in questo modo. Una bella sfida per il marketing delle case automobilistiche del futuro, insomma. Le domande etiche poste da Moral Machine sono effettivamente da far accapponare la pelle, dilemmi morali su cui nessuno vorrebbe dover prendere decisioni. Non è quindi certo una scelta che possiamo aspettarci gli ingegneri facciano per noi, ma dubito che anche i filosofi vorrebbero dire la loro su un simile argomento. È un punto molto spinoso perché, indubbiamente, va risolto. E chi si prenderà mai la responsabilità di programmare auto che abbiano la sicurezza dei propri passeggeri come priorità (o viceversa) a scapito del resto, non è dato sapere. Temi molto controversi, non c’è dubbio. Ma queste rimangono situazioni estreme. Estremamente irrealistiche ed estremamente ipotetiche. Il vero problema, anzi i problemi, sono ben più realistici, perché hanno a che fare con la quotidianità di ciò che si incontra sulle strade: l’imprevedibilità del comportamento umano.

Il vero problema della guida autonoma: le persone

Il vero problema delle auto a guida autonoma non è la tecnologia, né l’etica in situazioni estreme. C’è la preoccupazione che possano creare un problema di posti di lavoro, dato che si stima che circa 300.000 saranno resi obsoleti dai veicoli autonomi per il trasporto di persone e cose. Ma in realtà la storia ci ha più volte dimostrato che questi timori raramente sono catastrofici come si pensa (basta guardare alle statistiche legate all’avvento del Personal Computer, che ha inizialmente distrutto 3.5 milioni di posti di lavoro, ma ne ha creati 19.3 nei soli USA). No, il vero problema siamo noi. Gli esseri umani, e la nostra quotidiana, ordinaria stupidità. Per capire cosa significa basta pensare all’ultimo (in realtà, uno dei pochi) fatale incidente che ha coinvolto un’auto a guida totalmente autonoma durante un test-drive. Marzo 2018, Arizona: di notte, su una strada principale estremamente buia, una donna attraversa la strada portando la sua bici a mano. In quel momento arriva un’auto autonoma della flotta Uber, che non la vede finché non si trova praticamente sul cofano. Le immagini dell’incidente, riprese dalla telecamera esterna (che registra l’incidente) ed interna (che ci mostra il guidatore di controllo nell’abitacolo accorgersi di cosa stia accadendo quando è troppo tardi) sono scioccanti, e hanno fatto il giro del pianeta, decretando tante polemiche e anche un blocco temporaneo di tutti i test di questo tipo di veicolo. Il tutto è culminato, il 16 luglio di quest’anno, nella pubblicazione del primo schema universale di valutazione della sicurezza dei veicoli autonomi, proposto proprio da Uber perché sia utilizzato in tutto il settore. Il fatto è che si vede chiaramente la ciclista entrare nel campo di visibilità dell’auto solo quando i fari la investono di luce, ed è già troppo tardi. La macchina era equipaggiata di tutto: sensori, videocamere, una persona in carne e ossa per ulteriore sicurezza. Eppure non c’è programma che tenga quando un pedone sbuca all’improvviso. E chiunque abbia preso la macchina più di un paio di volte nella propria vita, sa che situazioni come questa sono più la norma che l’eccezione. La prontezza di riflessi del guidatore umano (unito a un po’ di fortuna) fa la differenza tra una tragedia e un sospiro di sollievo. Come si programma una cosa del genere? È difficile insegnare a una macchina anche il “buonsenso” necessario per qualsiasi essere umano alla guida: come fai a programmarla per rendersi conto che, se il veicolo davanti rallenta, sta probabilmente cercando parcheggio ed è opportuno mantenere maggiore distanza in caso lo trovi improvvisamente? E un’automobile eccessivamente cauta sarebbe inutile: troppo lenta per essere utile o addirittura nauseante per le continue frenate. LEGGI ANCHE: Un gruppo di ricercatori ha scoperto come ricaricare un’auto elettrica in 10 minuti Ciò che è facile per gli umani è difficile per le macchine: riconoscere facce e svolgere attività percettive ad esempio è un compito a cui ci ha preparati l’evoluzione di millenni, non un programma. Un bel problema, che a detta di molti (tranne Elon, che rimane fiducioso) obbliga a una lunga attesa prima che i veicoli a guida autonoma diventino davvero il presente della viabilità. Anche perché c’è un tema di tempistiche oggettive: l’anno scorso, in California, le macchine autonome hanno percorso 2 milioni di miglia. Tanto? No, se consideriamo la quantità di strada percorsa con macchine normali. Il che rende la bassa incidenza di eventi avversi con le auto a guida autonoma non statisticamente rilevante per valutarne la sicurezza. Secondo una stima di Mobileye, servirebbero 30 miliardi di miglia percorse nel mondo reale per valutare la sicurezza di questi veicoli con validità. “Con una flotta di 100 macchine, ci vorrebbero circa 1.000 anni. E ti conviene non cambiare il software nel frattempo, o dovresti ricominciare da capo”. Probabilmente insomma le auto di questo tipo avranno bisogno non solo della tecnologia, ma anche di un sistema di regole di funzionamento completamente nuovo, slegato da quello a cui siamo abituati con la guida manuale. Insomma, di essere “messe al sicuro” dall’errore umano, in qualche modo sul quale tutti i Paesi dovranno convenire e accordarsi.

E poi di tempo, tanto tempo, per testare il tutto.

Gli uomini sbagliano, le macchine no. Ed è questo che ci rende così difficile convivere in sicurezza.

Probabilmente insomma le auto di questo tipo avranno bisogno non solo della tecnologia, ma anche di un sistema di regole di funzionamento completamente nuovo, slegato da quello a cui siamo abituati con la guida manuale. Insomma, di essere “messe al sicuro” dall’errore umano, in qualche modo sul quale tutti i Paesi dovranno convenire e accordarsi.

E poi di tempo, tanto tempo, per testare il tutto.

Gli uomini sbagliano, le macchine no. Ed è questo che ci rende così difficile convivere in sicurezza.