Le intelligenze artificiali non sono il male (ma dipende da come le useremo)

Non tutti si fidano dei sistemi di AI, a volte perché sbagliano, altre perché non sbagliano mai

25 Ottobre 2018

L’intelligenza artificiale in tutte le sue forme sta entrando sempre più nelle nostre vite, tanto che questa buzzword è spesso usata a sproposito: c’è la vera intelligenza artificiale e quella che sembra una AI, ma non lo è. Possiamo includere in quest’ultima categoria tutte quelle tecnologie e dispositivi che fanno un uso intelligente di sensori e logiche programmate per portare a termine il loro compito. Sono dispositivi tecnologici e smart ma non hanno nulla a che fare con l’intelligenza artificiale. Un esempio di device smart ma tutt’altro che intelligente è il forno a microonde che pesa il cibo inserito al suo interno e, in base alla vostra indicazione sul tipo, decide il tempo di scongelamento, o in base alla ricetta scelta, effettua la successione di tempi e potenza di cottura, indicandovi cosa fare e quando farlo.

L’intelligenza artificiale artificiale, o Fauxtomation

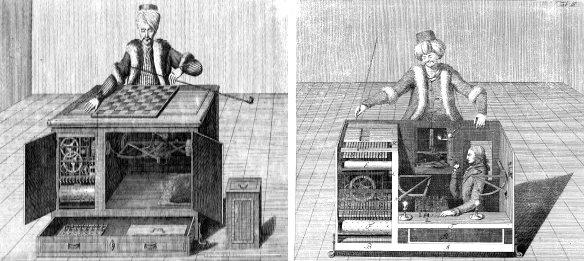

Astra Taylor (@astradisastra), scrittrice e documentarista, ha battezzato questo fenomeno fauxtomation, falsa automazione, o anche “intelligenza artificiale artificiale”. Secondo la definizione da lei lanciata poco più di un anno fa su Twitter, fauxtomation è quando i lavoratori sono resi invisibili per mantenere l’illusione che le macchine e i sistemi sono più intelligenti di quanto lo siano effettivamente. Un fenomeno che è sempre esistito, basti ricordare l’automa capace di giocare a scacchi, il turco meccanico. Sì, quello che poi ha ispirato nel nome il servizio Amazon, Mechanical Turk. E con buona ragione. Nel 1800, Wolfgang Von Kempelen creò questo robot, con le sembianze di un turco, e girava il mondo stupendo le persone con le sue capacità di giocare a scacchi. Ma c’era il trucco: dentro il meccanismo si nascondeva una persona. Era quella a decidere le mosse.

Se pensiamo che nessuno oggi potrebbe farsi raggirare da un trucco tanto semplice, siamo in errore.

Spesso e volentieri le aziende, anche giganti come Facebook, sfruttano la magia che desta l’espressione “intelligenza artificiale” per magnificare nuove feature o servizi, o per giustificare certe imperfezioni in essi, dato che sarebbe una tecnologia in fase di sviluppo e miglioramento.

“Qualunque tecnologia sufficientemente avanzata è indistinguibile dalla magia”. Così recita la terza legge sulla tecnologia del famoso scrittore di fantascienza Arthur C. Clarke.

Si parla spesso, per esempio, di quanto e come gli algoritmi intelligenti di Facebook siano capaci di gestire e moderare notizie, foto e segnalazioni, dimenticando che la decisione è in realtà presa da un umano.

Il documentario “The Moderators” di Field of Vision, girato l’anno scorso, mostra proprio il primo giorni di addestramento e lavoro di un gruppo di persone che decideranno se un contenuto dovrà trovare posto sui social oppure no.

Attenzione! Le immagini, per la natura stessa del soggetto, potrebbero disturbare la sensibilità di alcuni.

Ma c’era il trucco: dentro il meccanismo si nascondeva una persona. Era quella a decidere le mosse.

Se pensiamo che nessuno oggi potrebbe farsi raggirare da un trucco tanto semplice, siamo in errore.

Spesso e volentieri le aziende, anche giganti come Facebook, sfruttano la magia che desta l’espressione “intelligenza artificiale” per magnificare nuove feature o servizi, o per giustificare certe imperfezioni in essi, dato che sarebbe una tecnologia in fase di sviluppo e miglioramento.

“Qualunque tecnologia sufficientemente avanzata è indistinguibile dalla magia”. Così recita la terza legge sulla tecnologia del famoso scrittore di fantascienza Arthur C. Clarke.

Si parla spesso, per esempio, di quanto e come gli algoritmi intelligenti di Facebook siano capaci di gestire e moderare notizie, foto e segnalazioni, dimenticando che la decisione è in realtà presa da un umano.

Il documentario “The Moderators” di Field of Vision, girato l’anno scorso, mostra proprio il primo giorni di addestramento e lavoro di un gruppo di persone che decideranno se un contenuto dovrà trovare posto sui social oppure no.

Attenzione! Le immagini, per la natura stessa del soggetto, potrebbero disturbare la sensibilità di alcuni.

La fiducia nei confronti dell’intelligenza artificiale

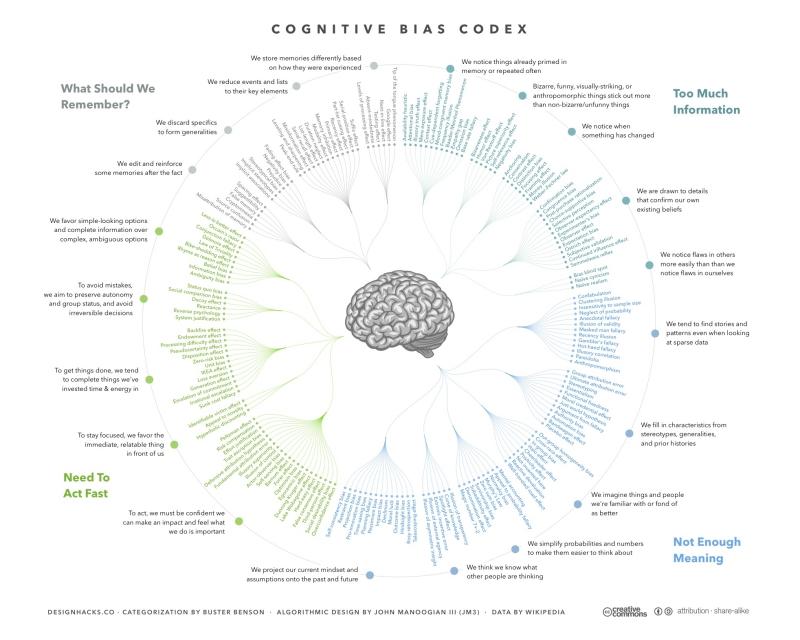

Ma cosa c’entra tutto questo con la fiducia nelle intelligenza artificiale? Il tentativo di mascherare l’intervento umano e presentare i successi come aspetti positivi di una implementazione di sistemi di AI non mette però al riparo dalle ricadute degli errori commessi. Tanto per citare uno, il più famoso ma non l’unico, la fotografia della bambina vietnamita che scappa, spogliata dai suoi vestiti dalle bombe al napalm, e che i sistemi di Facebook hanno censurato, perché mostrava nudità. Ma non sono solo le ricadute negative della faxutomation a provocare sfiducia nelle intelligenze artificiali. Un altro aspetto critico e fondamentale per istillare fiducia è l’eliminazione del Bias negli algoritmi. Non importa quale sistema si utilizzi per creare e addestrare una AI, i suoi algoritmi (e quindi i suoi risultati) saranno influenzati dai bias cognitivi degli umani che la creano e addestrano, e difficilmente potranno essere migliori. Senza dimenticare quanto afferma James Hender, direttore dell’istituto per l’esplorazione dei dati e applicazioni al politecnico Rensselaer, che, interpellato da IBM, dichiara: “Le AI possono essere utilizzate per il bene della società. Ma possono essere usate per produrre altri tipi di impatto sociale, in cui il bene di un uomo è il male per un altro. Dobbiamo rimanere consapevoli di questo”. LEGGI ANCHE: Di chi è la colpa se l’intelligenza artificiale sbaglia Sono ben 188 i bias cognitivi che affliggono noi esseri umani e i rischi qualcuno venga trasmesso sono elevati. Se non bastassero questi due aspetti, occorre considerare anche l’etica.

Automobili che si guidano da sole, sistemi d’arma intelligenti e altri dispositivi dotati di AI devono spesso prendere decisioni difficili anche per un essere umano.

Decisioni etiche che è ancora più difficile trasmettere ad una macchina poiché, come dichiara Vijay Saraswat, scienziato capo della IBM compliance solutions: “Che significato ha la nozione di etica per una macchina a cui non importa se quelli intorno continuano ad esistere, che non ha sentimenti, che non può soffrire, che non sa cosa siano i diritti fondamentali?”

Secondo gli scienziati interpellati da IBM per il suo studio “Building trust in AI”, instillare una morale nei sistemi di intelligenza artificiale non è facile, perché l’umanità non condivide un unico sistema di valori. Quale andrebbe insegnato, dunque?

Esiste un test predisposto dal MIT di Boston, nel quale dovreste decidere cosa dovrebbe fare una automobile a guida autonoma in diverse condizioni critiche. Alla fine del test della moral machine, così l’hanno battezzata al MIT, potrete confrontare quanto le vostre decisioni siano condivise da chi vi ha preceduto nel test.

Falsa automazione, bias e sistema etico però non bastano a spiegare perché in molti non si fidino delle intelligenze artificiali.

Un ultimo aspetto riguarda la mancata trasparenza degli algoritmi: come delle scatole nere, i sistemi prendono decisioni di cui non è dato sapere il fondamento.

Questo aspetto ha causato il fallimento di un progetto di diagnostica precoce del cancro, creato da IBM, Watson for oncology.

Nonostante i 14 mila pazienti trattati, quando i dottori dovevano interagire col sistema, c’erano due situazioni possibili: il sistema confermava la diagnosi del dottore oppure la contraddiceva.

Nel primo caso i dottori percepivano che il sistema fosse inutile e non producesse alcun valore aggiunto, nel secondo lo bollavano, semplicemente come incompetente, dato che il sistema non era in grado di spiegare come, analizzando la mole di dati a disposizione, fosse arrivato ad una conclusione diversa.

LEGGI ANCHE: Intelligenza Artificiale: così le macchine vedranno i tumori

Un problema, quello della oscurità degli algoritmi, che mina la fiducia nei sistemi che prendono decisioni di altro genere, per esempio, i sistemi che valutano se concedere un prestito a qualcuno, o che decidono se vendere o acquistare titoli azionari, o se l’aereo in avvicinamento è amico o nemico o, ancora, se l’aero passeggeri è in volo stabile e livellato oppure no.

Sono molti i casi in cui questi algoritmi per ragioni diverse, hanno fallito o, per assurdo, proprio perché non lo hanno fatto, creano timore e sfiducia nelle persone.

E non sempre sono persone qualunque: sono oltre 3mila gli scienziati e personaggi, tra cui Elon Musk e il team di sviluppo di Google Deep Mind che hanno firmato, insieme con 241 organizzazioni, una petizione presentata all’ONU contro lo sviluppo di sistemi di arma autonomi, i cosiddetti Robot killer.

Una petizione identica a quella presentata da ben 26 nazioni: Algeria, Argentina, Austria, Bolivia, Brasile, Cile, Cina, Colombia, Costa Rica, Cuba, Djibouti, Ecuador, Egitto, Ghana, Guatemala, Vaticano, Iraq, Messico, Nicaragua, Pakistan, Panama, Peru, Palestina, Uganda, Venezuela, Zimbabwe.

Se non bastassero questi due aspetti, occorre considerare anche l’etica.

Automobili che si guidano da sole, sistemi d’arma intelligenti e altri dispositivi dotati di AI devono spesso prendere decisioni difficili anche per un essere umano.

Decisioni etiche che è ancora più difficile trasmettere ad una macchina poiché, come dichiara Vijay Saraswat, scienziato capo della IBM compliance solutions: “Che significato ha la nozione di etica per una macchina a cui non importa se quelli intorno continuano ad esistere, che non ha sentimenti, che non può soffrire, che non sa cosa siano i diritti fondamentali?”

Secondo gli scienziati interpellati da IBM per il suo studio “Building trust in AI”, instillare una morale nei sistemi di intelligenza artificiale non è facile, perché l’umanità non condivide un unico sistema di valori. Quale andrebbe insegnato, dunque?

Esiste un test predisposto dal MIT di Boston, nel quale dovreste decidere cosa dovrebbe fare una automobile a guida autonoma in diverse condizioni critiche. Alla fine del test della moral machine, così l’hanno battezzata al MIT, potrete confrontare quanto le vostre decisioni siano condivise da chi vi ha preceduto nel test.

Falsa automazione, bias e sistema etico però non bastano a spiegare perché in molti non si fidino delle intelligenze artificiali.

Un ultimo aspetto riguarda la mancata trasparenza degli algoritmi: come delle scatole nere, i sistemi prendono decisioni di cui non è dato sapere il fondamento.

Questo aspetto ha causato il fallimento di un progetto di diagnostica precoce del cancro, creato da IBM, Watson for oncology.

Nonostante i 14 mila pazienti trattati, quando i dottori dovevano interagire col sistema, c’erano due situazioni possibili: il sistema confermava la diagnosi del dottore oppure la contraddiceva.

Nel primo caso i dottori percepivano che il sistema fosse inutile e non producesse alcun valore aggiunto, nel secondo lo bollavano, semplicemente come incompetente, dato che il sistema non era in grado di spiegare come, analizzando la mole di dati a disposizione, fosse arrivato ad una conclusione diversa.

LEGGI ANCHE: Intelligenza Artificiale: così le macchine vedranno i tumori

Un problema, quello della oscurità degli algoritmi, che mina la fiducia nei sistemi che prendono decisioni di altro genere, per esempio, i sistemi che valutano se concedere un prestito a qualcuno, o che decidono se vendere o acquistare titoli azionari, o se l’aereo in avvicinamento è amico o nemico o, ancora, se l’aero passeggeri è in volo stabile e livellato oppure no.

Sono molti i casi in cui questi algoritmi per ragioni diverse, hanno fallito o, per assurdo, proprio perché non lo hanno fatto, creano timore e sfiducia nelle persone.

E non sempre sono persone qualunque: sono oltre 3mila gli scienziati e personaggi, tra cui Elon Musk e il team di sviluppo di Google Deep Mind che hanno firmato, insieme con 241 organizzazioni, una petizione presentata all’ONU contro lo sviluppo di sistemi di arma autonomi, i cosiddetti Robot killer.

Una petizione identica a quella presentata da ben 26 nazioni: Algeria, Argentina, Austria, Bolivia, Brasile, Cile, Cina, Colombia, Costa Rica, Cuba, Djibouti, Ecuador, Egitto, Ghana, Guatemala, Vaticano, Iraq, Messico, Nicaragua, Pakistan, Panama, Peru, Palestina, Uganda, Venezuela, Zimbabwe.