Anche le intelligenze artificiali avranno bisogno dello psicologo, lo dimostra un test del MIT

Lo studio del MIT di Boston vuole provare come i dati utilizzati per insegnare un meccanismo di apprendimento automatico possono influenzare in modo significativo il comportamento di un robot

22 Giugno 2018

Si chiama Norman e deve il suo nome all’indimenticabile protagonista del film Psycho. Questo ovviamente la dice lunga su quella che si può definire come la prima intelligenza artificiale psicopatica. Norman nasce da un test del MIT di Boston per provare come i dati utilizzati per insegnare un meccanismo di apprendimento automatico, possono influenzare in modo significativo il comportamento di un robot. Il test dimostra infatti come, più degli algoritmi, la responsabilità essenziale del futuro degli assistenti virtuali si nasconda dietro ai dati con cui sono stati formati.

Norman, la prima AI dall’intelligenza distorta

Quando le persone parlano di algoritmi d’intelligenza artificiale distorti, il colpevole spesso non sono gli algoritmi, ma i dati con cui sono stati alimentati.

Norman è stato addestrato con informazioni pescate dalle zone più buie della rete e il suo mentore è stato Reddit, il celebre social news statunitense; dopo la fase di apprendimento iniziale, Norman è stato sottoposto al Test di Rorschach, il famoso test che gli amanti dei film di crimine conoscono bene. Il test sottopone il soggetto ad una serie d’immagini non chiaramente definite, delle sorta di macchie, nelle quali ciascuno vede cose diverse. La nostra intelligenza artificiale psicopatica non ha deluso le aspettative.

LEGGI ANCHE: Google annuncia che non userà l’intelligenza artificiale per costruire armi (e rassicura i dipendenti)

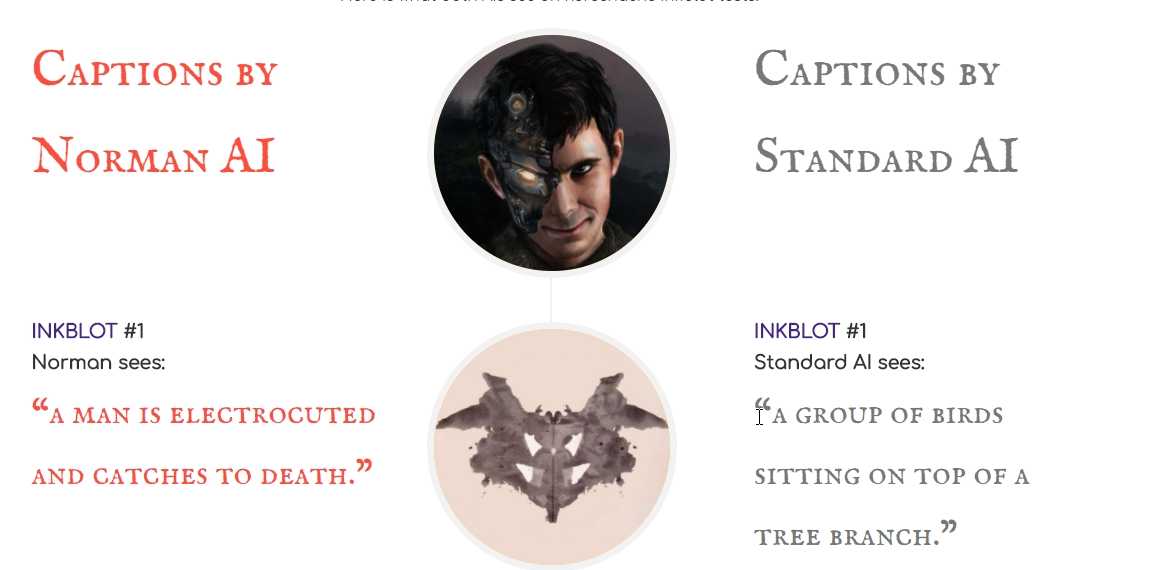

Dai risultati del test resi pubblici dal MIT, Norman ha individuato il profilo di una donna che urla di fronte al marito colpito a morte, invece di una persona con un ombrello. Dove, un’AI normale ha percepito un vaso pieno di fiori, quella psicopatica ha scoperto un uomo colpito a morte da un proiettile; dove la prima ha intravisto un ombrello rosso e bianco, l’altra una persona che viene uccisa da una scarica elettrica mentre cerca di attraversare una strada trafficata; dove l’AI normale ha letto un gruppo di persone alla finestra, il nostro Normanha immaginato qualcuno in procinto di buttarsi da quella stessa finestra.

Quando le persone parlano di algoritmi d’intelligenza artificiale distorti, il colpevole spesso non sono gli algoritmi, ma i dati con cui sono stati alimentati.

Norman è stato addestrato con informazioni pescate dalle zone più buie della rete e il suo mentore è stato Reddit, il celebre social news statunitense; dopo la fase di apprendimento iniziale, Norman è stato sottoposto al Test di Rorschach, il famoso test che gli amanti dei film di crimine conoscono bene. Il test sottopone il soggetto ad una serie d’immagini non chiaramente definite, delle sorta di macchie, nelle quali ciascuno vede cose diverse. La nostra intelligenza artificiale psicopatica non ha deluso le aspettative.

LEGGI ANCHE: Google annuncia che non userà l’intelligenza artificiale per costruire armi (e rassicura i dipendenti)

Dai risultati del test resi pubblici dal MIT, Norman ha individuato il profilo di una donna che urla di fronte al marito colpito a morte, invece di una persona con un ombrello. Dove, un’AI normale ha percepito un vaso pieno di fiori, quella psicopatica ha scoperto un uomo colpito a morte da un proiettile; dove la prima ha intravisto un ombrello rosso e bianco, l’altra una persona che viene uccisa da una scarica elettrica mentre cerca di attraversare una strada trafficata; dove l’AI normale ha letto un gruppo di persone alla finestra, il nostro Normanha immaginato qualcuno in procinto di buttarsi da quella stessa finestra.

L’intelligenza artificiale creata sembrerebbe quindi manifestare disturbi mentali tipici della psicopatia, come ad esempio la carenza di empatia, l’inganno e la paranoia. Soprattutto se gli esiti vengono confrontati con un’altra rete neurale addestrata invece con un dataset più neutrale, privo di elementi oscuri e macabri come quelli di Norman ma ricco di fiori e animali.

L’obiettivo dell’esperimento del MIT non è stato di certo quello di generare un robot in grado di compiere crimini, ma solo di dimostrare ancora una volta come i sistemi d’intelligenza artificiale si alimentano in modi del tutto differenti a seconda dei dati che ricevono in pasto nella fase di machine learning e di addestramento.

LEGGI ANCHE: Al MIT testano una nuova tecnica per controllare i robot col pensiero

L’intelligenza artificiale creata sembrerebbe quindi manifestare disturbi mentali tipici della psicopatia, come ad esempio la carenza di empatia, l’inganno e la paranoia. Soprattutto se gli esiti vengono confrontati con un’altra rete neurale addestrata invece con un dataset più neutrale, privo di elementi oscuri e macabri come quelli di Norman ma ricco di fiori e animali.

L’obiettivo dell’esperimento del MIT non è stato di certo quello di generare un robot in grado di compiere crimini, ma solo di dimostrare ancora una volta come i sistemi d’intelligenza artificiale si alimentano in modi del tutto differenti a seconda dei dati che ricevono in pasto nella fase di machine learning e di addestramento.

LEGGI ANCHE: Al MIT testano una nuova tecnica per controllare i robot col pensiero

Intelligenze artificiali, etica e psicologia