Dobbiamo davvero temere le intelligenze artificiali quanto gli umani?

Non solo ci ruberanno il lavoro, ma se copieranno gli uomini diventeranno razziste, ciniche e sessiste

14 Febbraio 2018

Di intelligenza artificiale se ne parla ormai da decenni: il famoso test per individuare una AI fu proposto da Alan Turing già nel 1950. Il rapido sviluppo tecnologico e il miglioramento delle condizioni di vita hanno poi permesso una diffusione massiva di strumenti elettronici e applicazione software. Ora che i sistemi artificiali sono largamente diffusi nel nostro quotidiano, riemergono antichi timori anticipati dalla fantascienza e dai moderni luddisti in un distopico futuro: l’umanità schiava delle macchine e delle intelligenze artificiali, disoccupata, annoiata e inebetita. Si tratta solo di una visione troppo catastrofica o dovremmo realmente fare attenzione?

I disastri dell’intelligenza artificiale

A sentire i grandi colossi come Google, Amazon e Facebook che ne fanno già largo uso, sembrerebbe che le AI possano offrirci un mondo migliore, senza fake news, con assistenti digitali sempre a disposizione per risolvere ogni nostro problema e desiderio (magari!) e automobili che ci portano a destinazione in totale sicurezza. Addirittura prevedendo ed evitando incidenti prima che accadano. Ma è davvero così? In rete si trovano tantissimi filmati (molti anche fake) in cui si vede una Tesla evitare un incidente. Questo video del 2016, che mostra un incidente evitato in Olanda, è diventato virale e ha ottenuto moltissime visualizzazioni. Meno noto è che ci siano stati anche incidenti, alcuni mortali, che gli strumenti con cui sono equipaggiate le Tesla non sono riuscite a prevedere ed evitare. Come quello costato la vita a Joshua Brown, sempre nel 2016. Nel 2009, il volo Air france 447 si inabissò nel bel mezzo del oceano atlantico per un serie di circostanze sfortunate, tra cui l’azione di un sistema di intelligenza artificiale installato sull’airbus A330 che li trasportava da Rio de Janeiro verso Parigi.

Nel 2003 invece fu il sistema di intelligenza artificiale che guidava i missili Patriot ad abbattere ben due aerei amici: un tornado britannico ed un F18 della marina americana.

Come spesso accade, non è un solo fattore a causare il problema e non lo è stato nemmeno in questi incidenti, quindi attribuire la responsabilità di questi tristi eventi all’uso di software intelligenti e interattivi sarebbe superficiale. Ragionando per assurdo con questi parametri, potremmo considerare che tutti questi veicoli sono dotati di ruote, dunque la ragione degli incidenti risiede nella gomma.

LEGGI ANCHE: Il futuro dell’intelligenza artificiale è nel marketing creativo

Appare però evidente il denominatore comune dell’automazione estrema che richiede intervento umano minimo; la soglia di esperienza umana richiesta che si abbassa e l’incapacità di gestire un’emergenza quando gli avanzati sistemi si disinseriscono può causare gravi conseguenze.

La domanda giusta allora forse è: il vero rischio è che le intelligenze artificiali rendano noi umani stupidi? No, il grosso rischio e che ci imitino, diventando come noi ma molto, molto più potenti.

Nel 2009, il volo Air france 447 si inabissò nel bel mezzo del oceano atlantico per un serie di circostanze sfortunate, tra cui l’azione di un sistema di intelligenza artificiale installato sull’airbus A330 che li trasportava da Rio de Janeiro verso Parigi.

Nel 2003 invece fu il sistema di intelligenza artificiale che guidava i missili Patriot ad abbattere ben due aerei amici: un tornado britannico ed un F18 della marina americana.

Come spesso accade, non è un solo fattore a causare il problema e non lo è stato nemmeno in questi incidenti, quindi attribuire la responsabilità di questi tristi eventi all’uso di software intelligenti e interattivi sarebbe superficiale. Ragionando per assurdo con questi parametri, potremmo considerare che tutti questi veicoli sono dotati di ruote, dunque la ragione degli incidenti risiede nella gomma.

LEGGI ANCHE: Il futuro dell’intelligenza artificiale è nel marketing creativo

Appare però evidente il denominatore comune dell’automazione estrema che richiede intervento umano minimo; la soglia di esperienza umana richiesta che si abbassa e l’incapacità di gestire un’emergenza quando gli avanzati sistemi si disinseriscono può causare gravi conseguenze.

La domanda giusta allora forse è: il vero rischio è che le intelligenze artificiali rendano noi umani stupidi? No, il grosso rischio e che ci imitino, diventando come noi ma molto, molto più potenti.

La rivolta delle macchine

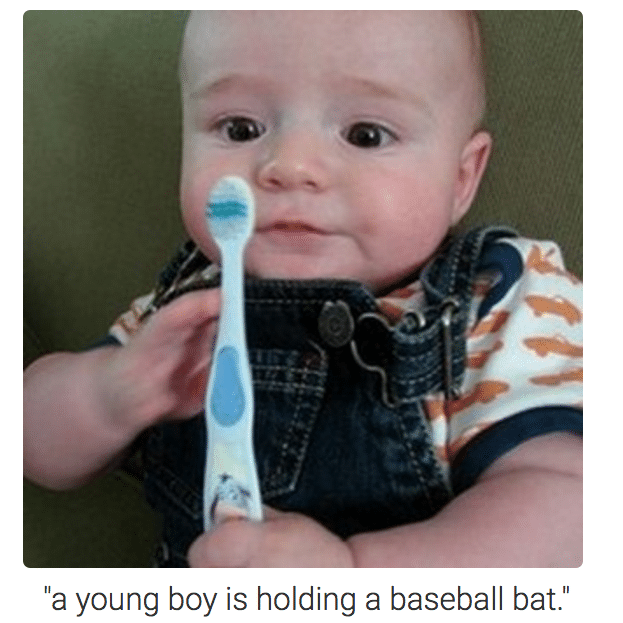

Che dire della storia di Tay, il chatbot di Microsoft gestito da una intelligenza artificiale che, dopo poche ore di apprendimento iniziò a pubblicare tweet razzisti e sessisti? Anche i sistemi AI di riconoscimento immagini possono essere tratti in inganno, consapevolmente o meno. Nel primo caso si sfruttano dei contro-algoritmi per ingannarli, nel secondo sono i loro stessi algoritmi a mancare il riconoscimento. Così abbiamo il neonato con lo spazzolino che è percepito come un bambino con la mazza da baseball o la tartaruga riconosciuta come un fucile. Vi sembrano esempi troppo lontani dalla vita di tutti i giorni? Ormai sono diffusi i sistemi di riconoscimento facciale: sono nelle macchine fotografiche e negli smartphone che usiamo ogni giorno e, alcuni di questi algoritmi (con i loro bias) hanno impedito ad un cittadino asiatico di ottenere il suo passaporto in pochi clic: il sistema di riconoscimento delle foto rifiutava le sue “perché aveva gli occhi chiusi”.

A causa dello stesso problema, la macchinetta fotografica di una blogger asiatica continuava a segnalarle che strizzava gli occhi.

Vi sembrano esempi troppo lontani dalla vita di tutti i giorni? Ormai sono diffusi i sistemi di riconoscimento facciale: sono nelle macchine fotografiche e negli smartphone che usiamo ogni giorno e, alcuni di questi algoritmi (con i loro bias) hanno impedito ad un cittadino asiatico di ottenere il suo passaporto in pochi clic: il sistema di riconoscimento delle foto rifiutava le sue “perché aveva gli occhi chiusi”.

A causa dello stesso problema, la macchinetta fotografica di una blogger asiatica continuava a segnalarle che strizzava gli occhi.

Che dire dei sistemi di controllo di Facebook per verificare che gli utenti usino i propri veri nomi? Molti nativi americani si sono lamentati che il loro account fosse bloccato: cognomi come “creepingbear” (orso strisciante) non erano riconosciuti dal sistema come reali.

I sistemi di intelligenza artificiale sono ancora decisamente migliorabili: sono statisticamente impressionanti, ma inaffidabili in casi specifici.

LEGGI ANCHE: Ora puoi usare l’intelligenza artificiale di Google anche sul tuo sito

Che dire dei sistemi di controllo di Facebook per verificare che gli utenti usino i propri veri nomi? Molti nativi americani si sono lamentati che il loro account fosse bloccato: cognomi come “creepingbear” (orso strisciante) non erano riconosciuti dal sistema come reali.

I sistemi di intelligenza artificiale sono ancora decisamente migliorabili: sono statisticamente impressionanti, ma inaffidabili in casi specifici.

LEGGI ANCHE: Ora puoi usare l’intelligenza artificiale di Google anche sul tuo sito